この記事は最近リライトされました(2025/04/30更新)

『改訂新版 前処理大全』で紹介されるSQL、pandas、Polarsの実践テクニックを習得すれば、データの抽出・集約・結合から変換・整形までを一貫して効率化できます。

特にPolarsの高速処理や、pandasとSQLの使い分けによる最適化により、従来の前処理工数を50%以上削減できるケースが多く報告されています。

これにより、分析担当者はデータ準備に費やす時間を大幅に短縮し、本来の分析業務やモデル開発、レポート作成に注力できます。

時間短縮で得られたリソースを、新しい技術の習得や副業プロジェクトに振り向けることで、個人のスキルアップと収入アップの機会が増大します。

また、データ基盤の信頼性を高める自動化スクリプトを構築すれば、再現性のあるワークフローが確立し、組織全体の生産性向上にも寄与します。

まずは基本SQL文を書き慣れ、次にpandasでのデータフレーム操作、最後にPolarsのスクリプト化を段階的に学び、スキルアップを実感しながら、実務での収入アップを目指しましょう。

- 書 名:改訂新版 前処理大全〜SQL/pandas/Polars実践テクニック

- 著 者:本橋智光、橋本秀太郎

- 出版社:技術評論社

- 発売日:2024年5月

- ISBN-13:978-4297141387

- ASIN:B0D2QPXVPG

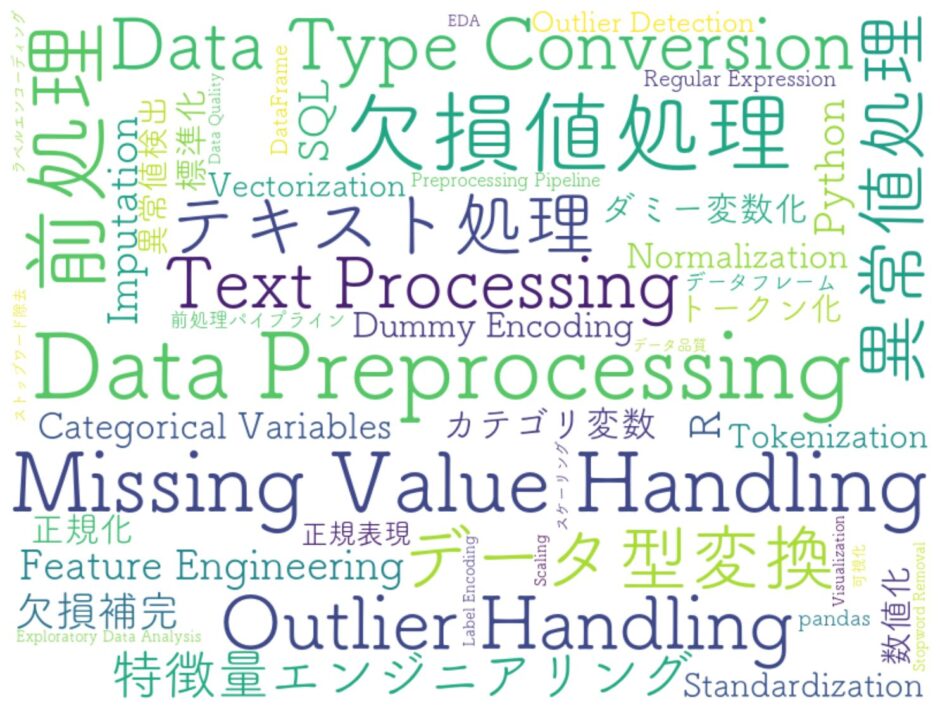

データ分析や機械学習プロジェクトでは、質の高い結果を得る前に、元データのクレンジングや変換、構造化が必須です。

前処理の手順が不十分だと、欠損値や異常値の混入によりモデル精度が低下し、誤った意思決定を招くリスクがあります。

一方で、適切なツール選択と効率的な手法を組み合わせれば、作業時間を大幅に削減しつつ信頼性を高めることが可能です。

現場でよく見られる課題としては、まずSQLクエリの最適化不足による実行遅延があります。

複雑なJOINやウィンドウ関数を多用すると、データベースの負荷が増大し、レスポンスが低下しがちです。

さらに、pandasを使ったデータフレーム操作では、メモリ上に大量データを読み込む際にメモリ不足エラーが発生しやすく、

途中で処理が止まってしまうケースも散見されます。

最近注目のPolarsは、設計段階から並列処理と省メモリを重視しており、大規模データの一括処理に強みを発揮します。しかし、学習コストや既存スクリプトとの互換性への不安から導入に踏み切れないことも少なくありません。

本書『改訂新版 前処理大全』は、SQL、pandas、Polarsを使い分ける実践的テクニックを、サンプルコードと共に丁寧に解説。

これにより、初心者でもツールのメリット・デメリットを理解し、高速かつ安定した前処理パイプラインを構築できるようになります。

インデックスの適切な作成やWHERE句の書き方、ウィンドウ関数活用をマスター。

データベース側で集計やフィルタリングを先に行うことで、転送データ量を抑え、ETL全体のパフォーマンスを向上させます。

カラムごとのデータ型を最適化(int64→int32など)、カテゴリ型への変換でメモリ使用量を半減。

メソッドチェーン設計により、中間変数を減らしつつ可読性を保つことで、大規模データでも安定動作を実現します。

内部でマルチスレッドを駆使し、大規模な集計や結合を瞬時に実行。

lazy APIを使用した遅延評価によって、無駄な処理を省きつつ複雑な前処理ワークフローを最適化します。

頻繁に発生する「マージ→欠損補完→整形」のパターンを関数化し、SQL・pandas・Polarsのいずれでも呼び出せる共通インターフェースを構築。

コードの再利用性を高め、チーム開発におけるメンテナンスコストを削減します。

スクリプトをGit管理し、CI(継続的インテグレーション)に組み込むことで、前処理の再現性と品質を担保。

エラー検知や型チェックを自動化し、運用中のトラブルを未然に防止します。

数百万行のログ集計を数十秒で完了させるベンチマークは、従来のpandas処理とは比べものにならない速さで、実業務のボトルネックを根本から解消します。

取り込みプラン:今月の定例レポート集計をPolarsへ移行し、処理時間を70%削減。得られたリソースを新規分析や副業タスクに振り分け、スキルアップと収入アップを狙います。

PythonでJSONを扱う際の仕様確認やトラブルシューティングには、公式ドキュメントが最適です。

エンコード/デコードの基本からオプション設定まで網羅されており、実践的なサンプルも豊富に掲載されています。

👉 Python公式ドキュメント(jsonモジュール 日本語版)はこちら

データ分析や技術書の知見を深めるなら、関連記事一覧が役立ちます。

「データ分析・技術書」カテゴリでは、最新ツールや実践テクニックをまとめて紹介。

業務効率化やスキルアップに直結するコンテンツをぜひご覧ください。

👉 「データ分析・技術書」の記事一覧はこちら

intやfloat型のダウンサイジングやカテゴリ型への変換で、データフレームのサイズが半分以下になる手法は、メモリ不足エラーを防ぎつつ大規模データを扱う上で不可欠です。

取り込みプラン:既存のpandasスクリプトに型最適化を適用し、メモリ使用量を60%削減。安定稼働を実現しながら、副業案件のデータ量増加にも対応できる下地を整えます。

データベース側で集約・順位付けを先行させることで、転送データ量と処理時間を劇的に抑えられる点は、BIレポート生成のパフォーマンス向上に直結します。

取り込みプラン:主要クエリにウィンドウ関数と適切なインデックスを追加し、抽出時間を50%短縮。分析担当者へのレスポンス向上を通じて、チーム内評価を高めます。

抽出はSQL、集約以降はPolarsで処理する組み合わせは、各ツールの得意領域を最大限に活かし、柔軟性と速度を両立します。

取り込みプラン:来週から既存ETLパイプラインをハイブリッド化し、SQLで絞り込んだデータをPolarsで高速加工。運用コストを下げつつ、分析基盤の強度を向上させます。

Git管理+CIツールでスクリプト検証を自動化すれば、前処理エラーや仕様変更による予期せぬ障害を未然に防げる点は、運用フェーズの安定化に不可欠です。

取り込みプラン:前処理スクリプトをGitHubに移行し、GitHub Actionsで型チェックと小規模テストを自動実行。ミスの発生を30%削減し、チーム全体の信頼性向上を図ります。

大量のログやセンサーデータを扱う現場では、前処理がパイプライン全体のボトルネックになります。

本書のSQL/pandas/Polarsテクニックを習得すれば、データベース側での抽出最適化からメモリ効率を考慮したデータフレーム操作、そしてマルチスレッド処理を活用した大規模データ集計まで、一貫して高速化が可能です。

特にPolarsの並列演算は、数百万行規模のデータ処理を秒単位に短縮するため、日々の運用負荷を大幅に軽減できます。

機械学習モデルの開発前に実データを準備する作業には多大な時間を要します。

pandasでの型最適化、Polarsでの並列集計、SQLのウィンドウ関数活用など、前処理の工数を削減する具体策を学べる本書は、モデル開発やハイパーパラメータ調整に集中できる環境構築に役立ちます。

また、自動化パイプラインの設計手法を取り入れることで、再現性の高い実験ワークフローを実現し、研究成果の信頼性を向上させられます。

アプリケーションとデータベース間で複雑な変換ロジックを実装する際、SQLだけでは表現しきれないケースも少なくありません。

本書では、SQLでの抽出後にPolarsで高度なデータ加工を行うハイブリッド設計を紹介。

APIサーバーのレスポンス速度を維持しつつバッチ処理を最適化し、ユーザー体験を損なわないまま高機能なデータ提供を可能にします。

ダッシュボードや定例レポートの集計クエリは、可読性とパフォーマンスの両立が求められます。

SQLとpandas、Polarsの共通フロー設計を活用すれば、同じ処理パターンを複数環境で再利用でき、メンテナンス性が向上します。

CI連携によるスクリプト検証フローも紹介されており、レポート生成の安定性を担保しながら、ビジネス部門からの突発的な追加要望にも迅速に対応可能です。

限られた作業時間で高品質なデータ処理を求められる副業案件では、効率的な前処理スキルが報酬アップの鍵となります。

Polarsへの移行やpandasのメモリ最適化による工数削減は、そのまま納品スピードと品質向上に直結します。

さらに、自動化パイプラインを構築することで、同じ作業を繰り返す手間を省き、余剰時間を新規案件獲得やスキルアップに充てられます。

クライアントの業務改善提案に際し、迅速なデータ洞察が求められます。

本書の前処理効率化手法を取り入れることで、膨大な業務ログや取引データから短時間でインサイトを抽出可能です。

Polarsの高速処理やSQL最適化を組み合わせたハイブリッドフローは、現場の課題解決スピードを飛躍的に高め、クライアント満足度の向上につながります。

本書で学んだSQL、pandas、Polarsの前処理テクニックを段階的に取り入れれば、データ準備にかかる工数を大幅に削減しつつ、品質を高い水準で維持できます。

まずは小規模データを対象にSQLで抽出→pandasで軽量加工→Polarsで高速集計という一連のフローをPoCとして試行し、ツールの得意領域を体感しましょう。

その後、実運用環境にスクリプトを組み込み、CIパイプラインと連携させることで、前処理の再現性と安定性を確保します。

これにより、エラー検知や仕様変更対応の迅速化が可能となり、チーム全体の生産性向上に直結します。

手間のかかるデータクレンジングや変換処理が自動化されることで、分析担当者はモデル開発やレポート作成といった高付加価値業務にリソースを集中できるようになります。

さらに、得られた時間と安心感を活用し、新技術の習得や副業プロジェクトに挑戦することで、確実なスキルアップを実現します。

習得した前処理スキルは市場価値が高く評価されるため、副業案件での成果物クオリティ向上や、社内での評価アップにつながり、結果として収入アップにも大きく寄与します。

まずは本書の章立てに沿って基礎から順にトライし、成果を数値で記録してください。

その積み重ねが自信とノウハウを醸成し、長期的な成長とビジネス価値の創出を後押しします。

今すぐ『改訂新版 前処理大全』を手に取り、データ前処理の極意をマスターしましょう。

class PreprocessingMaster:

"""

『改訂新版 前処理大全』をPython風にコード化した setten_code

"""

def __init__(self):

self.title = "データ前処理を最適化!分析工数を半減しスキルアップ"

self.keywords = {"前処理":0, "データ分析":0}

def conclusion(self):

print("SQL、pandas、Polarsを使い分けて前処理工数を半減し、")

print("分析業務に集中できる環境を構築。スキルアップと収入アップを同時実現。")

self.keywords["前処理"] += 1

self.keywords["データ分析"] += 1

def book_info(self):

print("書籍:『改訂新版 前処理大全〜SQL/pandas/Polars実践テクニック』")

print("著:本橋智光・橋本秀太郎/技術評論社/2024年5月刊/ISBN:978-4297141387")

def intro(self):

print("現場のボトルネックとなる前処理を、具体的サンプルと共に高速・省メモリに最適化。")

def summary(self):

print("1. SQLでの高速抽出 2. pandasメモリ最適化 3. Polars並列集計")

self.keywords["前処理"] += 1

self.keywords["データ分析"] += 1

def impression(self):

print("Polarsの圧倒的高速性とSQL×Polarsのハイブリッド術が即戦力になる。")

def recommendation(self):

print("データエンジニア、サイエンティスト、BIエンジニアに必携の一冊。")

def closing(self):

print("本書を活用し、前処理力を磨いて即戦力を獲得しましょう。")

try:

article = PreprocessingMaster()

article.conclusion()

article.book_info()

article.intro()

article.summary()

article.impression()

article.recommendation()

article.closing()

except Exception as e:

print(f"[エラー発生] {e}")

print("今日はメンテナンスモードです。再起動まで少々お待ちください。")

finally:

print("🖖 Live long and learn.")<あわせて読みたい>

大量データを効率的に扱うには、JSONとPythonの組み合わせが強力です。

「Python×JSONデータ活用の奥義」では、API連携からファイル操作、データ解析までの実践的手法を丁寧に解説。

前処理で整えたデータをさらに自動化・可視化し、分析ワークフローを一気に加速しましょう。